Escribir contenido para la Iglesia es un privilegio. Nuestra labor se asemeja, en muchos sentidos, a la de los levitas en tiempos de Esdras: mientras el escriba leía el libro de la ley ante el pueblo, ellos ayudaban a la congregación a comprender su significado (Neh 8:1-8). Si bien en BITE no nos enfocamos en la exégesis detallada de la Biblia, sí usamos sus principios y verdades para analizar nuestra historia como pueblo de Dios, interpretar nuestro presente desde una cosmovisión bíblica y prepararnos para el futuro.

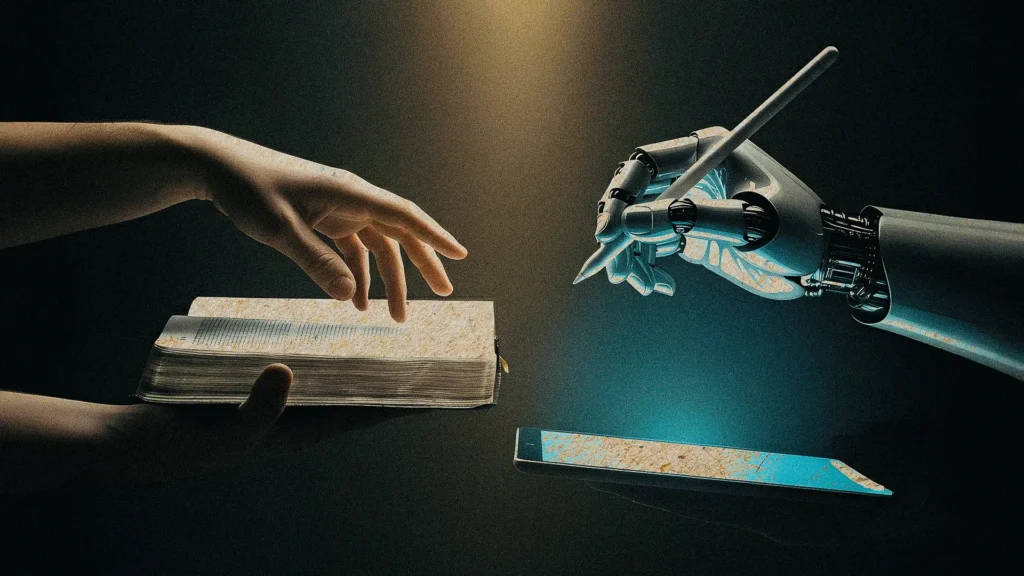

Tanto BITE como cientos de otros ministerios dedicados a crear contenido para el pueblo de Dios nos hemos enfrentado a un inmenso dilema desde el 30 de noviembre de 2022, cuando OpenAI lanzó la primera versión de ChatGPT. Hasta entonces, la inteligencia artificial de acceso público no era masiva ni conversacional; su uso se asociaba a tareas específicas como jugar ajedrez o darle órdenes a Alexa o Siri. Pero ese día marcó un punto de inflexión: conversar gratuitamente con una IA para casi cualquier propósito se volvió posible para todos. Desde entonces, los avances en los modelos generativos se han multiplicado exponencialmente.

El dilema es el siguiente: ¿usaremos la IA para crear contenido para el pueblo de Dios? Aunque ya contábamos con herramientas tecnológicas muy útiles, ninguna podía generar texto a partir de nuestras instrucciones; por primera vez, se hizo posible obtener un texto sin que unas manos humanas lo escribieran directamente. Ahora bien, nuestra identidad como cristianos precede a nuestro rol como creadores de contenido, lo que nos obliga a representar a Dios fielmente en el mundo. Esta responsabilidad nos exige una cautela extrema con los posibles resultados de nuestras acciones, especialmente al observar los graves errores que ya se han cometido con el uso de la IA.

Un caso emblemático de estos fracasos, que sirve como una clara advertencia, es el escándalo de la prestigiosa revista Sports Illustrated. A finales de 2023, se reveló que la publicación no solo había utilizado IA para generar contenido de baja calidad, sino que había ido un paso más allá: inventó por completo a los autores. Eran perfiles falsos con nombres, biografías y fotografías de rostros que nunca existieron, todos generados con inteligencia artificial. Este no fue un simple error técnico, sino un acto de engaño deliberado, una “realidad” fabricada. Después de que todo se descubrió, tal fue la presión mediática, que el CEO de la revista fue despedido semanas más tarde.

Ante estos riesgos, la tentación podría ser descartar por completo el uso de la IA, pero tal postura podría ser exagerada. La historia nos muestra que, aunque toda tecnología conlleva peligros, la solución nunca ha sido el rechazo absoluto. Internet, por ejemplo, alberga pornografía, pero la respuesta del pueblo cristiano no es destruir las computadoras, sino usar esa misma red para subir sermones a YouTube y difundir contenido edificante. Evidentemente, la Biblia no nos da una instrucción directa como “no usaréis la IA”, pero sí nos da mandatos explícitos como “no darás falso testimonio” o “no cometerás adulterio”. Por lo tanto, necesitamos principios que nos guíen para utilizar esta nueva herramienta para la gloria de Dios y cumplir los mandamientos que sí son explícitos.

Este artículo está estructurado en torno a tres principios éticos generales. Cada uno de ellos aborda algunos de los que, a mi parecer, son los principales desafíos relacionados con el uso de la IA en la creación de contenido para la Iglesia. Es importante aclarar que por “creación de contenido” me refiero al amplio espectro de recursos que edifican al pueblo de Dios, tales como: artículos para sitios web, traducciones, publicaciones para redes sociales, material educativo en video y otros formatos similares. Aclaro: aquí no incluyo la elaboración de sermones para la iglesia local, aunque sí hago una referencia sobre esto al abordar el tercer principio.

Expongo aquí los tres principios, para luego abordarlos detalladamente uno por uno:

1. La inteligencia artificial debe servir para potenciar el intelecto y las capacidades creativas humanas, no para reemplazarlos.

2. La inteligencia artificial debe ser utilizada con completa transparencia.

3. El ser humano siempre debe responsabilizarse por el uso de la IA.

1. La inteligencia artificial debe servir para potenciar el intelecto y las capacidades creativas humanas, no para reemplazarlos.

El mayor temor que suscita la inteligencia artificial en la escritura es la posibilidad del reemplazo humano. El mes pasado, Microsoft recortó alrededor de 6000 puestos de trabajo, y muchos analistas adjudican estas decisiones a la implementación de la IA. Según el Fondo Monetario Internacional, estos modelos de lenguaje afectarán al 40% de los empleos en todo el mundo. Sin embargo, para un cristiano consciente del mandato cultural, el objetivo será siempre que la IA sirva para potenciar sus capacidades creativas, no para suplantarlas. En palabras de Jeremy Utley, profesor adjunto de creatividad e IA de la Universidad de Stanford, “La IA es una herramienta para aumentar y amplificar drásticamente nuestra creatividad”.

En el relato de Génesis 1, Dios crea el mundo y declara que es bueno. No obstante, no lo concibió como una obra terminada e intocable, sino que designó al ser humano como su administrador. A pesar de que la creación ya era “buena en gran manera”, Dios le encomendó a Adán la tarea de nombrar a los animales. ¿Con qué fin? Para que Su representante participara activamente en el cuidado del mundo, aportando belleza, calidad y orden. El hombre no fue llamado simplemente a “mantener” la bondad del mundo, sino, bajo la dirección divina, a cultivarla y mejorarla. De aquí se desprende que la labor de Adán estaba intrínsecamente ligada a la calidad del trabajo: se requería esfuerzo para que lo bueno llegara a ser aún mejor.

Trasladando este principio a nuestro contexto, en el que la IA ha llegado para quedarse e influye en todos los ámbitos, el llamado del cristiano a buscar la máxima calidad posible en sus producciones cobra una nueva urgencia. De hecho, la calidad del resultado final es el criterio diferenciador clave entre un uso de la IA que potencia y uno que reemplaza. La razón es simple: es imposible que la IA por sí sola cree algo de mejor calidad que una persona, pues el ser humano puede aprovechar sus propias capacidades sumadas a las de la inteligencia artificial, mientras que la IA solo dispone de sus propios recursos.

Quiero ilustrar esto con un ejemplo profesional concreto. Ante la tarea de redactar un contrato de servicios comerciales, un abogado tiene tres caminos:

- Primero, el tradicional: hacerlo todo manualmente. Aunque es la forma clásica, este enfoque hoy resulta menos competitivo. El abogado podría tardar horas en investigar y comparar cláusulas, y correría el riesgo de pasar por alto jurisprudencia muy reciente o soluciones contractuales más innovadoras que una IA analizaría en segundos. Su calidad se limita a su conocimiento y a su tiempo.

- Segundo, la delegación irresponsable: pedirle a la IA que lo reemplace. El abogado simplemente le pide: “Redacta un contrato de servicios comerciales”. Este camino no solo es negligente y constituye una mala praxis profesional, también implica deshonestidad, y como veremos en un momento). El resultado será un documento genérico, probablemente con información incorrecta o cláusulas inaplicables en su jurisdicción, que ignora por completo las necesidades específicas de su cliente y lo expone a riesgos legales.

- Tercero, la sinergia profesional: usar la IA para potenciar su conocimiento y experiencia. Este es un buen camino hacia un producto de calidad. Aquí, el abogado actúa como director de proyecto y estratega, pero utiliza esta herramienta virtual como un asistente de investigación y redacción. Así pues, comienza por definir la estrategia: los objetivos del cliente, los riesgos a mitigar y los puntos no negociables. Luego, utiliza la IA para tareas específicas, con una instrucción como: “Analiza la jurisprudencia de los últimos cinco años sobre cláusulas de propiedad intelectual en contratos de software en México”. Con esta investigación, el abogado elabora un prompt (instrucción para que la inteligencia artificial genere una respuesta acertada) detallado y le pide a la IA que estructure un primer borrador del contrato.

Una vez que la IA entrega el borrador, comienza el trabajo crítico del experto. El abogado lo revisa, identifica las debilidades y usa la IA para iterar: “Reformúlame esta cláusula para que sea menos ambigua”. Finalmente, realiza la edición definitiva, donde aporta su valor irreemplazable: ajusta el tono, alinea las cláusulas al riesgo de su cliente y aplica su juicio ético. El resultado es un contrato que no solo es sólido y está actualizado, sino que ha sido estratégicamente diseñado a la medida de su cliente. Se trata de una calidad que supera a la IA que opera sin dirección.

Llegados a este punto, es necesario abordar una cuestión clave: esta perspectiva de la tecnología como un potenciador de las capacidades humanas genera controversia dependiendo del área de aplicación. Casi nadie objetaría el uso de la IA para identificar llamadas fraudulentas o para optimizar el tráfico de una ciudad. Sin embargo, si hablamos de escribir un ensayo académico para una revista especializada, surgen numerosas preguntas éticas —algunas de las cuales abordaré más adelante—, y si nos referimos a la escritura de un sermón, ni hablar.

No obstante, más allá de la controversia que pueda generar en ciertas disciplinas, el principio de “potenciar el intelecto y las capacidades creativas humanas, no reemplazarlos” sigue siendo una guía fundamental. Consideremos que la tecnología se ha introducido en todos los ámbitos desde hace siglos. En el contexto específico de la comunicación para la Iglesia, los cristianos de los primeros siglos prefirieron el códice al rollo para facilitar el acceso a la Escritura. En el siglo XVI, Martín Lutero se valió de la imprenta para diseminar sus ideas. En la era digital, hemos afrontado el desafío de crear libros electrónicos, compartir sermones en YouTube y ofrecer clases de seminario en formato de podcast.

En cada caso, el buen uso de la tecnología ha servido para potenciar las capacidades del creyente que busca comunicar la Palabra de Dios fielmente mientras enfrenta los desafíos de su tiempo. Considero que con la inteligencia artificial no debería ser distinto. Su uso es valioso siempre que sirva para aumentar nuestras capacidades.

Para cerrar este principio, resulta útil una analogía del Dr. John D. Ferrer (aunque, como lo anotaré en el siguiente principio, no estoy de acuerdo con todas sus ideas en torno a este tema): el hecho de que yo pueda levantar una carga pesada con un montacargas no me convierte en alguien fuerte. Entonces, ¿debería usarlo? Depende del propósito. Si lo uso para que me reemplace en el gimnasio y levante las pesas por mí, soy simplemente alguien débil con una ilusión de fuerza, un mediocre con ínfulas de competencia. Para ser fuerte, ¡necesito seguir entrenando! Sin embargo, si la tarea es levantar un camión de varias toneladas, es sensato utilizarlo, porque el montacargas no moverá la carga a menos que yo lo dirija.

Así, la era actual nos invita no solo a seguir “yendo al gimnasio”, sino también a aprender a operar el “montacargas”. Aunque toda ilustración tiene sus límites —la redacción de contenido cristiano precede por milenios a la IA y no necesita de ella—, creo que el punto queda claro: no buscamos ser reemplazados, sino potenciados.

2. La inteligencia artificial debe ser utilizada con completa transparencia.

En el contexto de la creación de contenido para la Iglesia, una de las mayores preocupaciones gira en torno al falso testimonio y la mentira. “No darás falso testimonio contra tu prójimo” (Dt 5:20) no solo es el octavo mandamiento del Decálogo, sino que apunta directamente a la naturaleza de Dios y a Su voluntad para nosotros. “Dios no es hombre, para que mienta”, declara Números 23:19; por tanto, los cristianos, como portadores de la imagen de Cristo, debemos ser sumamente cuidadosos con la falsedad. ¿Acaso no pasó Jesús buena parte de Su ministerio terrenal confrontando la hipocresía de los fariseos?El punto de partida es, por tanto, indiscutible: la mentira queda descartada. La pregunta que permanece es: ¿en qué momento mentimos al usar la IA? ¿Valerse de esta herramienta implica necesariamente ser hipócritas y engañar a nuestro prójimo?

El problema del “autor”

La postura del Dr. John Ferrer es que, si la IA nos ayuda a escribir el contenido, entonces estamos mintiendo. Él dice lo siguiente:

Si estás usando la IA para escribir tu blog o artículo en línea (…), la escritura misma fue producida por un generador de escritura. Por lo tanto, no eres el único autor, porque la IA escribió una porción significativa del artículo, blog o libro mientras afirmas que la autoría es solamente tuya. En ese caso, la IA no solamente te “ayuda”. Ustedes dos son coautores. Afirmar autoría por material escrito que no escribiste, es engañoso en el mejor de los casos y deshonesto en el peor.

Según él, si un chatbot generó parte de tu contenido, este también sería el autor. Sin embargo, ¿cuál es la definición de “autor”?

Ricardo Tavira Sánchez analizó la definición que diferentes e influyentes editoriales científicas —entre ellas Elsevier, Springer Nature, Wiley, JAMA y Cambridge University Press— utilizan para el término “autor”. Encontró que ninguna permite incluir a una herramienta de IA como coautor en una investigación. ¿Por qué? Entre varias razones destacan dos. Primero, un autor es alguien a quien se le puede responsabilizar moralmente por el escrito y que tiene derechos sobre su producción. Es decir, una herramienta como ChatGPT no puede presentar una demanda por robo de ideas ni se le pueden exigir responsabilidades legales por sus afirmaciones. Hablaré más sobre el tema de la responsabilidad en mi tercer principio, pero el punto es este: la IA no es un autor en tanto que no puede asumir dicha responsabilidad. La segunda razón es que la IA no puede crear nada sin la intervención humana. Incluso la acción de proporcionar un simple prompt establece que la autoría es del ser humano, no de la IA.

Llegado este punto, es crucial hacer una aclaración: existe una diferencia fundamental entre la persona que utiliza la IA para que le haga el trabajo y la que hace su trabajo usando la IA. Aquí es donde el primer principio resulta clave para discernir entre la autenticidad y el engaño. Si la única aportación de una persona a un texto es una instrucción genérica, su labor no solo está siendo mediocre; también está actuando con deshonestidad. Se estaría atribuyendo la autoría de una obra a la que solo ha contribuido con un prompt, por lo que, en rigor, no es un autor en absoluto: ¡no ha producido nada que merezca ser leído!

Muy distinta es la situación de quien, en su proceso creativo, emplea la IA con 100 prompts diferentes, valiéndose de la herramienta para refinar y expandir las ideas que surgen de su propia mente. Es la misma diferencia que existe entre el músico que usa un sintetizador para orquestar una melodía compleja y aquel que simplemente presiona un botón para reproducir una secuencia predeterminada y aun así la publica como propia.

Ahora, si para algún hermano el hecho de que una IA genere parte de su texto puede entrar en conflicto con su conciencia, ese motivo es lo suficientemente válido y no debería juzgarse; si decide no usar la IA para generar texto por esta razón, glorificará a Dios. En lo personal, estoy de acuerdo con la postura de estas editoriales: el hecho de que el ser humano sea quien da la instrucción lo convierte en el autor final que se ha valido de una herramienta.

Observo este mismo principio en el uso de la tecnología en muchos contextos, incluso antes de la aparición de la IA. Es la persona quien hace el café, aunque utilice una máquina para el filtrado; es quien crea una presentación audiovisual, aunque utilice plantillas de PowerPoint o Canva; es el piloto quien dirige el avión, aunque use el piloto automático durante gran parte del vuelo; y es el analista quien determina la salud financiera de una empresa, aunque un software procese miles de datos y genere los gráficos. Los ejemplos son innumerables. El punto es este: el ser humano es el autor del texto cuando ha sido el autor del prompt.

El problema del robo intelectual

Ahora, habiendo abordado el asunto de la autoría, creo que necesitamos considerar otro problema relacionado con la mentira: el plagio y el robo intelectual. Además de “No darás falso testimonio”, el Decálogo también nos dice “No hurtarás” (Dt 5:19). The Authors Guild (en español, el gremio de escritores) es la organización de autores más grande y antigua de Estados Unidos. Ellos explican el problema del robo intelectual de la siguiente forma:

Para empezar, ten en cuenta que, por ahora, todos los principales modelos de lenguaje grandes (LLM) —inteligencia artificial generativa para texto— se basan en cientos de miles o más libros y un sinfín de artículos robados de sitios web piratas. Esta es la mayor infracción masiva de derechos de autor de obras de autores que jamás se haya visto, y fue realizada por algunas de las empresas más ricas del mundo. Es un robo —una transferencia de riqueza de creadores de clase media a las arcas de los multimillonarios— y estamos luchando contra ello.

Dicho de otra forma, si en el proceso de escritura se utiliza la IA, ya sea para generar texto o para investigar, es muy probable que la herramienta esté tomando ideas de otras personas y las esté ofreciendo sin citar a los autores originales. Creo que en el ámbito de la academia esto es grave: el esfuerzo que una persona ha hecho no está siendo reconocido, y a medida que avance el tiempo, será más difícil trazar los procedimientos de estas herramientas para procesar información.

En teoría, tanto las organizaciones que desarrollan las tecnologías de IA como las que las usan, están haciendo un esfuerzo por ser transparentes en explicar los procesos realizados por ellas. La Organización para la Cooperación y el Desarrollo Económico (OECD por sus siglas en inglés) establece ciertos principios éticos para la utilización de la IA. Uno de ellos es este:

Los actores de IA deben comprometerse con la transparencia y la divulgación responsable en relación con los sistemas de inteligencia artificial. Con este fin, deberían proporcionar información significativa, apropiada al contexto y consistente con el estado del arte (...) para ofrecer información clara y fácil de entender sobre las fuentes de datos/entrada, los factores, los procesos y/o la lógica que llevaron a la predicción, el contenido, la recomendación o la decisión, para permitir que los afectados por un sistema de IA comprendan el resultado.

Sin embargo, es claro que la IA tiene cada vez menos límites. En los primeros meses de 2025, una tendencia global inundó las redes sociales con imágenes generadas en el icónico estilo del estudio de animación japonés Studio Ghibli. Lo que comenzó como un fenómeno viral de asombro rápidamente se transformó en una intensa controversia. Artistas y aficionados criticaron la tendencia por trivializar y apropiarse indebidamente de décadas de trabajo artesanal, reavivando el debate sobre los límites de la creatividad y la infracción de derechos de autor. La magnitud de esta reacción fue tal que, según un análisis de la Montclair State University, las publicaciones en redes sociales que expresaban un sentimiento negativo sobre el tema superaron a las positivas en más de un 500%, demostrando cómo la capacidad casi ilimitada de la IA choca directamente con profundas consideraciones éticas y artísticas.

Frente a la capacidad cada vez más ilimitada de la IA, ¿cómo podemos ser transparentes en el uso de las ideas para crear contenido? Quisiera proponer tres formas. Primero, ser conscientes del funcionamiento general de la IA. Como ya lo mencionamos en el comentario de The Authors Guild, los “modelos de lenguaje grandes” (LLMs por sus siglas en inglés) utilizan inmensas cantidades de texto tomado de internet para entender, generar y predecir lenguaje humano de forma coherente y natural. En otras palabras, la IA en realidad no piensa ni sabe acerca de ningún tema, sino que predice usando texto creado por humanos. Así, si nos ofrece una buena idea, debemos ser conscientes de que la tomó de algún ser humano, o al menos la razonó basándose en las ideas de alguien más.

La segunda forma es usar a la IA para hacer un ejercicio riguroso de investigación. Teniendo en cuenta que esta herramienta no crea ideas, debemos hacer el mejor esfuerzo por trazar sus procedimientos, de forma que encontremos la fuente original de donde salió la información y la citemos debidamente. La gran mayoría de las herramientas actuales permiten que les solicitemos la fuente de su información. Incluso, aquellas que son particularmente útiles en la investigación, hacen el trabajo de citar con enlaces la información que están ofreciéndole al usuario —los cuales deben revisarse cuidadosamente, pues algunas herramientas se inventan la información y los links como tal—.

Una implicación práctica de esto es que, si una persona quiere buscar la máxima calidad y ser honesta en su escritura, el uso de la IA no le servirá principalmente para ahorrar tiempo. Por supuesto, habrá tareas que serán más fáciles (como encontrar una lista medios de comunicación que hablaron sobre una noticia o acomodar una referencia bibliográfica a cierto formato de citación), pero en otras, la IA desafiará al autor a emplear aún más tiempo en su escrito (por ejemplo, si le pide a la herramienta que le dé retroalimentación sobre su escrito o le hace preguntas sobre cómo abordar mejor a su audiencia).

La tercera forma es reconocer el uso de la IA en el proceso de la creación del contenido. Ya sea para la investigación, revisión, edición o retroalimentación en el proceso de escritura, el autor debe reconocer la utilización de la herramienta. Un buen ejemplo de esto es la declaración de Wired de cómo usará y no usará la IA —a pesar de la ironía que constituye el hecho de que una revista líder que habla sobre cómo las tecnologías emergentes afectan la cultura afirme que no usará la IA—.

Ahora, la especificidad de este reconocimiento puede variar. Personalmente, creo que un reconocimiento general es suficiente, algo como: “Este artículo fue redactado por [autor] y las ideas le pertenecen (a menos que el artículo especifique explícitamente lo contrario). Para la elaboración del texto, ha utilizado herramientas de IA como apoyo para la investigación y la edición [o cualquier otra ayuda]. El autor ha revisado cualquier participación de la IA en la construcción de su texto y es el responsable final del contenido y la veracidad de este”.

Otros medios de comunicación —como la Revista Internacional de Historia de la Comunicación— optarán por una mención muy específica sobre las secciones del texto en las que la IA participó de alguna forma y los contenidos encontrados a través de una de estas herramientas. Personalmente, creo que hacer esto es comparable a especificar en un trabajo de traducción en qué partes del texto se ha utilizado el diccionario, o detallar en una auditoría en dónde se ha hecho uso de un software contable. El uso de herramientas en algunas tareas laborales o incluso académicas ha estado presente por mucho tiempo antes de la aparición de la IA y no debería obligarnos a exponer todos los detalles de nuestros propios procesos de elaboración del contenido.

3. El ser humano siempre debe responsabilizarse por el uso de la IA.

Este principio es una implicación necesaria de los dos anteriores. Si buscamos cuidarnos de que la IA reemplace al ser humano y de que haya mentira o robo intelectual, entonces es necesario que siempre haya un responsable detrás de cada contenido. El nombre de una persona, de un autor, debe estar presente para que podamos pedirle cuentas de lo que ha dicho. Si se descubre que ha dicho mentiras poniéndose como el autor de algo que no escribió o que ha robado las ideas de otra persona, se le debe sancionar de alguna manera. Si el producto tiene la calidad de algo generado con prisa a través de la IA, se le debe llamar la atención sobre su mediocridad.

En este sentido, es increíblemente cínica aquella persona que, habiendo publicado algún contenido, culpe a la IA por algún error en el producto final. Lo mínimo que debe hacer el usuario de estas herramientas es revisar su contenido. Muchas organizaciones han documentado los diversos errores que cometen las tecnologías de IA, entre ellos las “alucinaciones” —invención de hechos, datos, citas y fuentes—, sesgos, proporción de información desactualizada, malinterpretaciones de las solicitudes, errores lógicos, inconsistencias, y un largo etc. La empresa de medios digitales CNET pasó una terrible vergüenza pública por crear artículos con IA en los que dio consejos financieros y tenían información ilógica o plagiada. Muchos consumidores se vieron afectados porque, evidentemente, los redactores no revisaron la información que publicaron.

Sin embargo, el principio de responsabilidad en el uso de la IA trasciende la simple tarea de verificar el contenido o de designar un culpable en caso de error, dado que estas precauciones ya eran válidas mucho antes de la llegada de ChatGPT. Como seres creados a la imagen de Dios, nuestra responsabilidad es más profunda y se extiende en tres direcciones: hacia nuestro prójimo, hacia nuestro Creador y hacia nosotros mismos. Este triple compromiso debe ser la brújula que guíe nuestro uso de cualquier herramienta tecnológica. De hecho, ya hemos abordado la primera de estas áreas —la responsabilidad hacia nuestro prójimo— al insistir en buscar la máxima calidad para nuestros lectores, no mentir sobre la autoría y asumir la rendición de cuentas final sobre lo que publicamos. Dicho de forma positiva, el uso de la IA debe demostrar que amamos a los demás. Me gustaría ahora profundizar en los otros dos compromisos.

Responsabilidad hacia nuestro Creador

Una idea central del Nuevo Testamento es que la salvación produce una transformación profunda en nuestro corazón, mente y conducta, que nos lleva a dedicar todo nuestro ser a buscar la gloria de Dios. Dos imágenes bíblicas describen esto perfectamente: la del siervo que invierte los talentos que su amo le confió para multiplicarlos en su nombre (como lo muestra la parábola en Mateo 25:14-30), y la de la persona que entrega su propio cuerpo como ofrenda. Sobre esto último, Pablo dice: “Por tanto, hermanos, les ruego por las misericordias de Dios que presenten sus cuerpos como sacrificio vivo y santo, aceptable a Dios, que es el culto racional de ustedes. Y no se adapten a este mundo, sino transfórmense…” (Ro 12:1-2).

En resumen, nuestra responsabilidad ante nuestro Creador como cristianos transformados es usar toda nuestra mente, nuestro corazón y nuestras fuerzas para Su gloria. Por tanto, la pregunta que debemos hacernos es: ¿me está llevando la IA a usar menos mi mente, mi corazón y mis fuerzas en este llamado?

Para ilustrar esto, tomemos el caso específico de la predicación. Primero, es fundamental aclarar que la predicación ocupa un lugar sagrado, muy por encima de otras formas de creación de contenido cristiano. Es el principal medio que Dios diseñó para que el pastor alimente a las ovejas de Cristo con la Palabra, y por eso debe ser abordada con un temor reverencial aún mayor. En este contexto, el pastor John Piper señala la gravedad de que un ministro le pida a ChatGPT que escriba su sermón, subcontratando así —y de forma gratuita— su deber principal:

No dejes que ChatGPT escriba el primer borrador de tu sermón para que luego tú lo revises, ajustes y personalices. Francamente, la idea me horroriza; me horroriza. Sé que siempre han existido recursos y sitios web para ayudar a los pastores a tomar atajos (…). No hay nada nuevo en esto, y siempre me ha parecido espantoso, por la siguiente razón: una de las cualificaciones para ser un anciano-pastor-predicador en la Biblia es el don o la habilidad para enseñar, didaktikos (1 Ti 3:2). Eso significa que debes tener la capacidad, el don, de leer un pasaje de la Escritura, entender la realidad de la que trata, sentir las emociones que debe suscitar, ser capaz de explicarlo a otros con claridad, ilustrarlo y aplicarlo para su edificación. Ese es un don que debes poseer. Es tu trabajo número uno. Si no lo tienes, no deberías ser pastor.

En otras palabras, si ChatGPT hace el sermón, el pastor no ha usado su mente, sus fuerzas y, sobre todo, su corazón para glorificar a Dios en el llamado específico que ha recibido. Incluso si a nivel cognitivo la IA puede estructurar mejor las ideas, el pastor está eludiendo su deber de enseñar. Si al final la congregación es edificada con ese discurso que ignora a la audiencia real, Dios habrá usado una herramienta tecnológica para bendecir a Su Iglesia (así como usó a la burra de Balaam), pero el predicador tendrá que rendir cuentas por su deshonestidad y mediocridad.

Quizás la predicación es un ejemplo extremo, pero el principio aplica a cualquier creación de contenido para la Iglesia. La pregunta es: ¿usamos la IA para desafiarnos a invertir más nuestro corazón, mente y fuerzas, o la subcontratamos para ahorrarnos el esfuerzo de trabajar para Dios? El problema no radica en ahorrar tiempo en tareas mecánicas, sino en que ese tiempo ganado no se reinvierta en un esfuerzo mayor para darle gloria. En esta línea, Piper nos invita: “Usemos ChatGPT (…) para obtener información, incluso para inspirarte, de la misma manera que usas comentarios, artículos, libros, canciones y poesía”.

Responsabilidad hacia nosotros mismos

De las responsabilidades hacia los demás y hacia nuestro Creador se deriva una tercera: la responsabilidad hacia nosotros mismos. Usando la imagen de un atleta que se disciplina para ganar la carrera, Pablo afirma que “esclaviza” su cuerpo para ser un mejor ministro del Evangelio (1 Co 9:24-27). El principio es que debemos administrar nuestras propias habilidades para glorificar a Dios y bendecir a otros. Esto implica que, así como el atleta disciplina su cuerpo, el creador de contenido cristiano debe cuidar y ejercitar su mente para servir mejor a los demás.

La historia del profesor australiano David M. Shaw, del Perth Bible College, ilustra bien este punto. En un artículo publicado el mes pasado, Shaw contó que les asignó a sus estudiantes la tarea de crear una bibliografía comentada sobre el pasaje de Ezequiel 34. Un estudiante entregó un trabajo que a primera vista parecía excelente, pues citaba artículos de revistas académicas y eruditos reconocidos. Sin embargo, al verificar las fuentes, el profesor descubrió que la IA había fabricado las referencias por completo. Por ejemplo, generó una cita de un supuesto artículo del experto Daniel I. Block, titulado “El pastor de Ezequiel: más allá de la acusación”. Tanto el autor como la revista eran reales, pero la investigación de Shaw confirmó que dicho artículo, al igual que otros en la lista, simplemente no existía.

La conclusión de Shaw fue que el estudiante, al saltarse todo el proceso de buscar, analizar y organizar la bibliografía, era el principal perjudicado. En sus palabras:

Un uso indebido de la IA elimina el arduo trabajo formativo de leer e investigar por cuenta propia, y en última instancia entorpecerá el desarrollo de uno. Por otro lado, el esfuerzo del estudio nos forma de maneras positivas, enseñándonos paciencia, perseverancia y humildad. Resulta que lidiar con un texto difícil o resumir el argumento de otra persona con nuestras propias palabras no se trata solo de obtener una calificación alta. El proceso en sí mismo es la recompensa por la forma en que moldea el tipo de persona en la que podemos convertirnos, tanto intelectual como espiritualmente.

La pregunta que queda, entonces, es esta: ¿la inteligencia artificial nos está haciendo mejores escritores, editores y creadores, o su uso está atrofiando nuestro intelecto? Mi convicción es que un uso apropiado de la IA, al igual que el montacargas de la analogía inicial, puede de hecho hacernos mejores, pues amplía nuestras capacidades y nos permite abordar desafíos más grandes. Sin embargo, si la usamos motivados por la pereza o la mediocridad, nos estaremos dañando a nosotros mismos y, en consecuencia, perjudicando a aquellos a quienes servimos.

Conclusión: un futuro con IA

Ciertamente, quedan muchos problemas y preguntas por resolver. Por ejemplo, si usamos la IA de forma masiva, ¿llegará un día en que nuestra escritura se asemeje tanto a la suya que sea imposible distinguirlas? ¿Es posible que, en el mundo editorial, las estructuras, estilos y tonos que adoptemos se vuelvan demasiado homogéneos? Quienes escribimos hoy podemos recordar fácilmente una época sin IA, pero este será un desafío particular para las nuevas generaciones, que crecen en un mundo donde estas herramientas ya lo permean todo.

La inteligencia artificial llegó para quedarse; no hay marcha atrás. Sin embargo, como sucede con los demás desafíos de este mundo, nuestra tarea como representantes de Dios es buscar soluciones sabias. Un enfoque purista, que ignore la existencia de estas herramientas, no nos llevará a ninguna parte. Solo a través de la exploración, la reflexión, la crítica y el uso responsable podremos superar los obstáculos que la IA misma plantea.

Con todo, estoy convencido de que, si somos diligentes al aplicar los tres principios presentados en este artículo, podremos mantener un uso ético de la IA sin comprometer la integridad de nuestro ministerio. Concluyo con un breve recordatorio de ellos:

1. La inteligencia artificial debe servir para potenciar el intelecto y las capacidades creativas humanas, no para reemplazarlos.

2. La inteligencia artificial debe ser utilizada con completa transparencia.

3. El ser humano siempre debe responsabilizarse por el uso de la IA.

Nota del editor: Este artículo fue redactado por David Riaño y las ideas le pertenecen (a menos que el artículo especifique explícitamente lo contrario). Para la elaboración del texto, ha utilizado herramientas de IA como apoyo para la investigación y la edición. El autor ha revisado cualquier participación de la IA en la construcción de su texto y es el responsable final del contenido y la veracidad de este.

Referencias y bibliografía

Sports Illustrated Published Articles by Fake, AI-Generated Writers | Futurism

How Stanford Teaches AI-Powered Creativity in Just 13 MinutesㅣJeremy Utley

Microsoft layoffs 2025: This division may be hit next week after 6,000 already laid off in May | MSN

The Ethics of AI in Writing | CrossExamined.org

AI Best Practices for Authors | Authors Guild

Política editorial sobre el uso de inteligencia artificial | Universidad de Sevilla

About WIRED’s Use of Generative AI | WIRED

Una IA escribió artículos en secreto para una de las webs más importantes: así le fue | El Español

What Are AI Hallucinations? | IBM

Should I Use AI to Help Me Write Sermons? | Desiring God

Spiritual Formation and Artificial Intelligence | The Gospel Coalition Australia

Apoya a nuestra causa

Espero que este artículo te haya sido útil. Antes de que saltes a la próxima página, quería preguntarte si considerarías apoyar la misión de BITE.

Cada vez hay más voces alrededor de nosotros tratando de dirigir nuestros ojos a lo que el mundo considera valioso e importante. Por más de 10 años, en BITE hemos tratado de informar a nuestros lectores sobre la situación de la iglesia en el mundo, y sobre cómo ha lidiado con casos similares a través de la historia. Todo desde una cosmovisión bíblica. Espero que a través de los años hayas podido usar nuestros videos y artículos para tu propio crecimiento y en tu discipulado de otros.

Lo que tal vez no sabías es que BITE siempre ha sido sin fines de lucro y depende de lectores cómo tú. Si te gustaría seguir consultando los recursos de BITE en los años que vienen, ¿considerarías apoyarnos? ¿Cuánto gastas en un café o en un refresco? Con ese tipo de compromiso mensual, nos ayudarás a seguir sirviendo a ti, y a la iglesia del mundo hispanohablante. ¡Gracias por considerarlo!

En Cristo,

|

Giovanny Gómez Director de BITE |